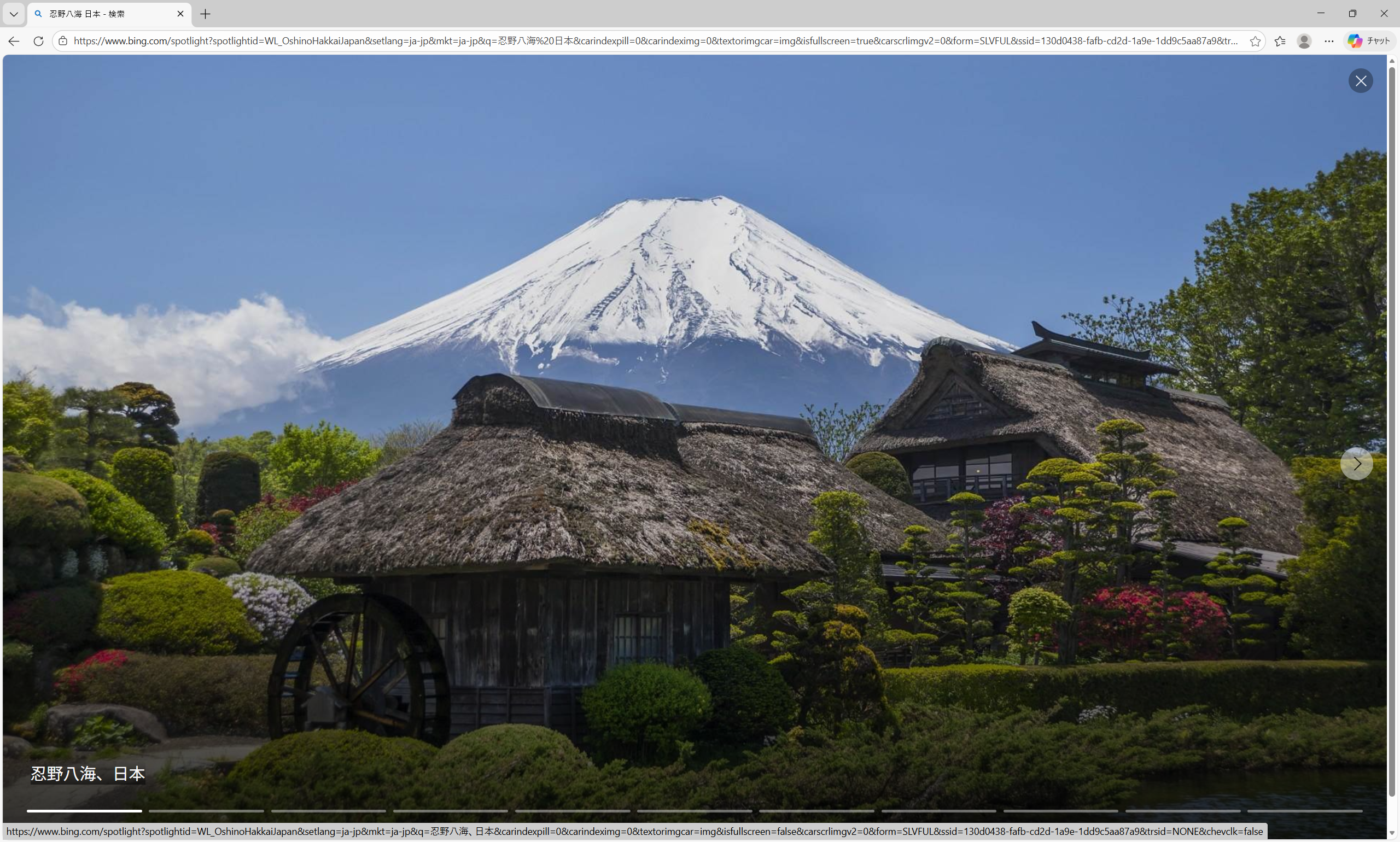

忍野八海

## 目的

ONNX モデル(model.onnx)を TensorRT でエンジン(model.plan)に変換する。

## 講師

Windows AI

## 環境

– RHEL10

– TensorRT コンテナ

– ホストとコンテナを以下で接続:

-v /home/chibi/models:/workspace

## docker 起動方法

sudo docker login nvcr.io -u ‘$oauthtoken’ -p nvapi- <あなたのNGC API Key> でlogin を済ませる。

次に dockerにはいる。

sudo docker run –rm –gpus all -it \

-v /home/chibi/models:/workspace \

nvcr.io/nvidia/tensorrt:24.02-py3

## ONNX ファイルの場所

ホスト:/home/chibi/models/model.onnx

コンテナ:/workspace/model.onnx

(同じファイル)

## エンジン生成

trtexec –onnx=/workspace/model.onnx –saveEngine=model.plan

## 成功確認

ls -al /workspace

例:

-rw-r–r– 1 root root 297236 model.plan

model.plan が生成されていれば成功。

## まとめ

• ONNX は “中間形式”

• PyTorch や TensorFlow のモデルを TensorRT が読める形にするための橋渡し

• 最終的に TensorRT が使うのは model.plan

データをコピペで使う場合はこちらを使ってください

コピペで使用時のデータ版