スイスのモルテラッチ氷河の固い氷の下を掘り進んでできたこの洞窟

desktop Arch Linux

Arch Linux Kernel6.15.5-arch1-1とPHP 8.4.10とSamba4.22.3がUpdateされました。

[root@arch ~]# uname -r

6.15.5-arch1-1

[root@arch ~]# php -v

PHP 8.4.10 (cli) (built: Jul 4 2025 12:41:44) (NTS)

Copyright (c) The PHP Group

Zend Engine v4.4.10, Copyright (c) Zend Technologies

[root@arch ~]# curl -V

curl 8.14.1 (x86_64-pc-linux-gnu) libcurl/8.14.1 OpenSSL/3.5.1 zlib/1.3.1 brotli/1.1.0 zstd/1.5.7 libidn2/2.3.7 libpsl/0.21.5 libssh2/1.11.1 nghttp2/1.66.0 nghttp3/1.10.1

Release-Date: 2025-06-04

Protocols: dict file ftp ftps gopher gophers http https imap imaps ipfs ipns mqtt pop3 pop3s rtsp scp sftp smb smbs smtp smtps telnet tftp ws wss

Features: alt-svc AsynchDNS brotli GSS-API HSTS HTTP2 HTTP3 HTTPS-proxy IDN IPv6 Kerberos Largefile libz NTLM PSL SPNEGO SSL threadsafe TLS-SRP UnixSockets zstd

[root@arch ~]# samba -V

Version 4.22.3

[root@arch ~]# cat /etc/os-release

NAME=”Arch Linux”

PRETTY_NAME=”Arch Linux”

ID=arch

BUILD_ID=rolling

ANSI_COLOR=”38;2;23;147;209″

HOME_URL=”https://archlinux.org/”

DOCUMENTATION_URL=”https://wiki.archlinux.org/”

SUPPORT_URL=”https://bbs.archlinux.org/”

BUG_REPORT_URL=”https://gitlab.archlinux.org/groups/archlinux/-/issues”

PRIVACY_POLICY_URL=”https://terms.archlinux.org/docs/privacy-policy/”

LOGO=archlinux-logo

[root@arch ~]#

-

最近の投稿

- Arch Linux Kernel6.15.5-arch1-1 PHP 8.4.10 Samba4.22.3 Update

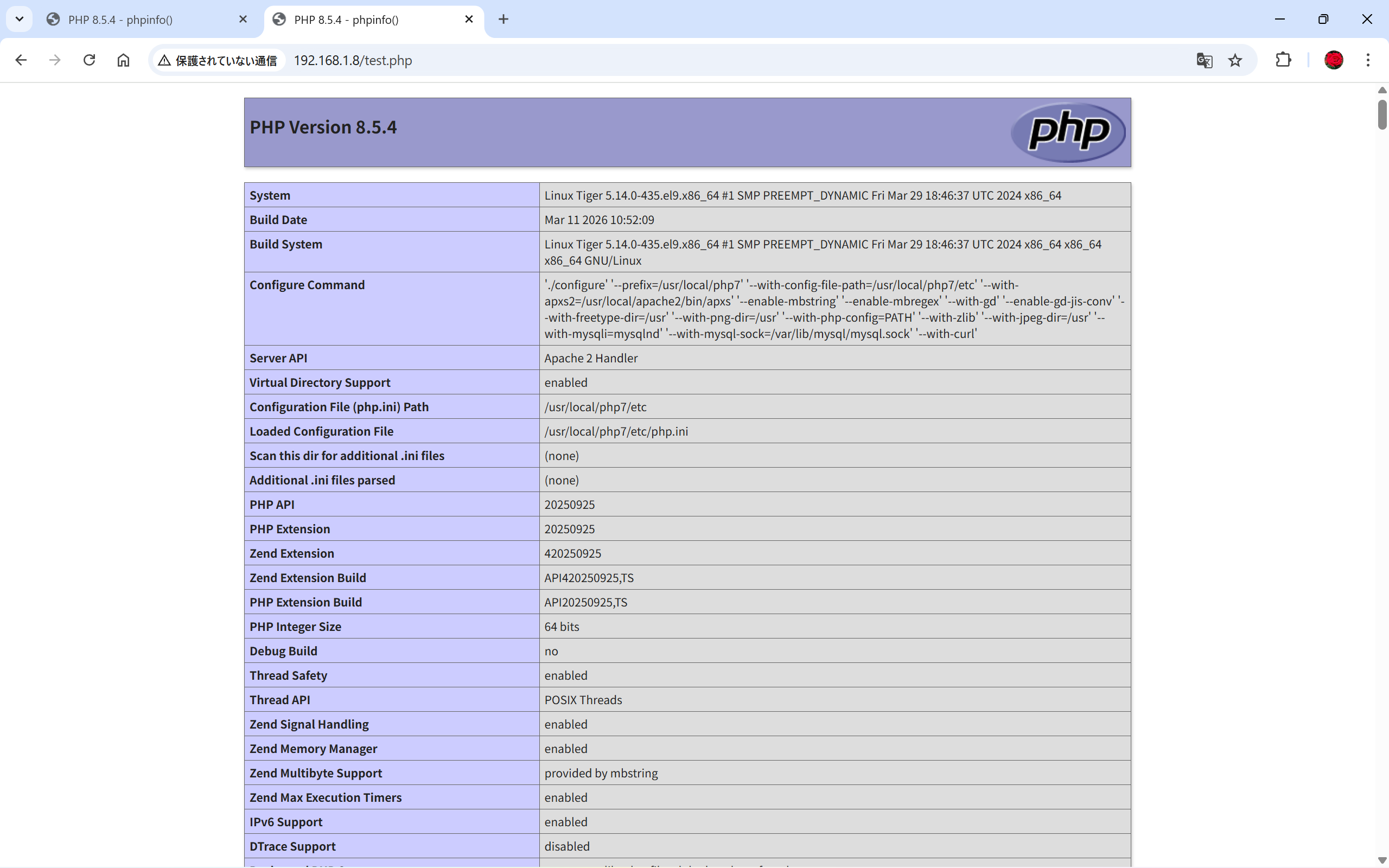

- PHP8.4.19 PHP 8.5.4 が公開

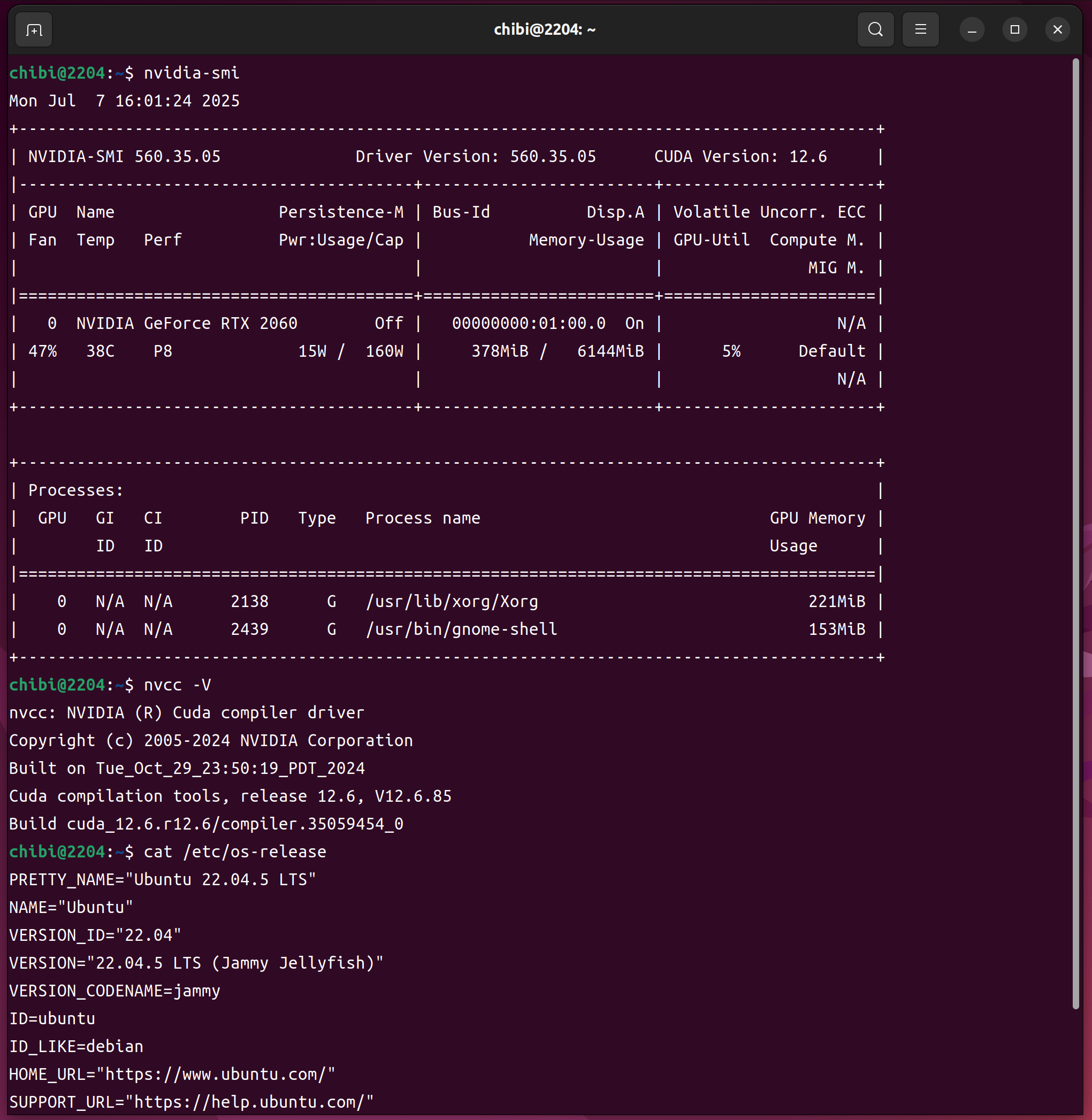

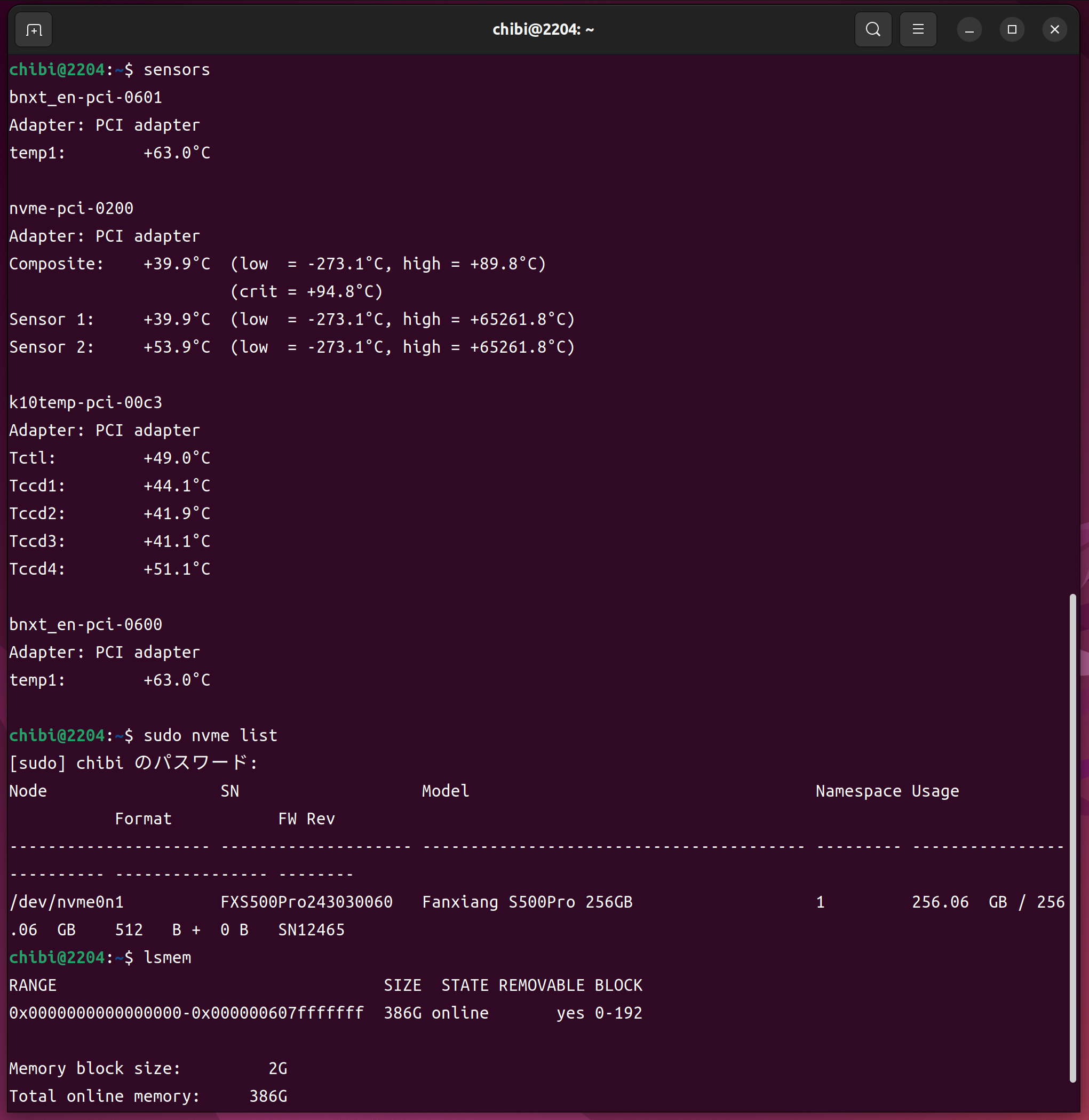

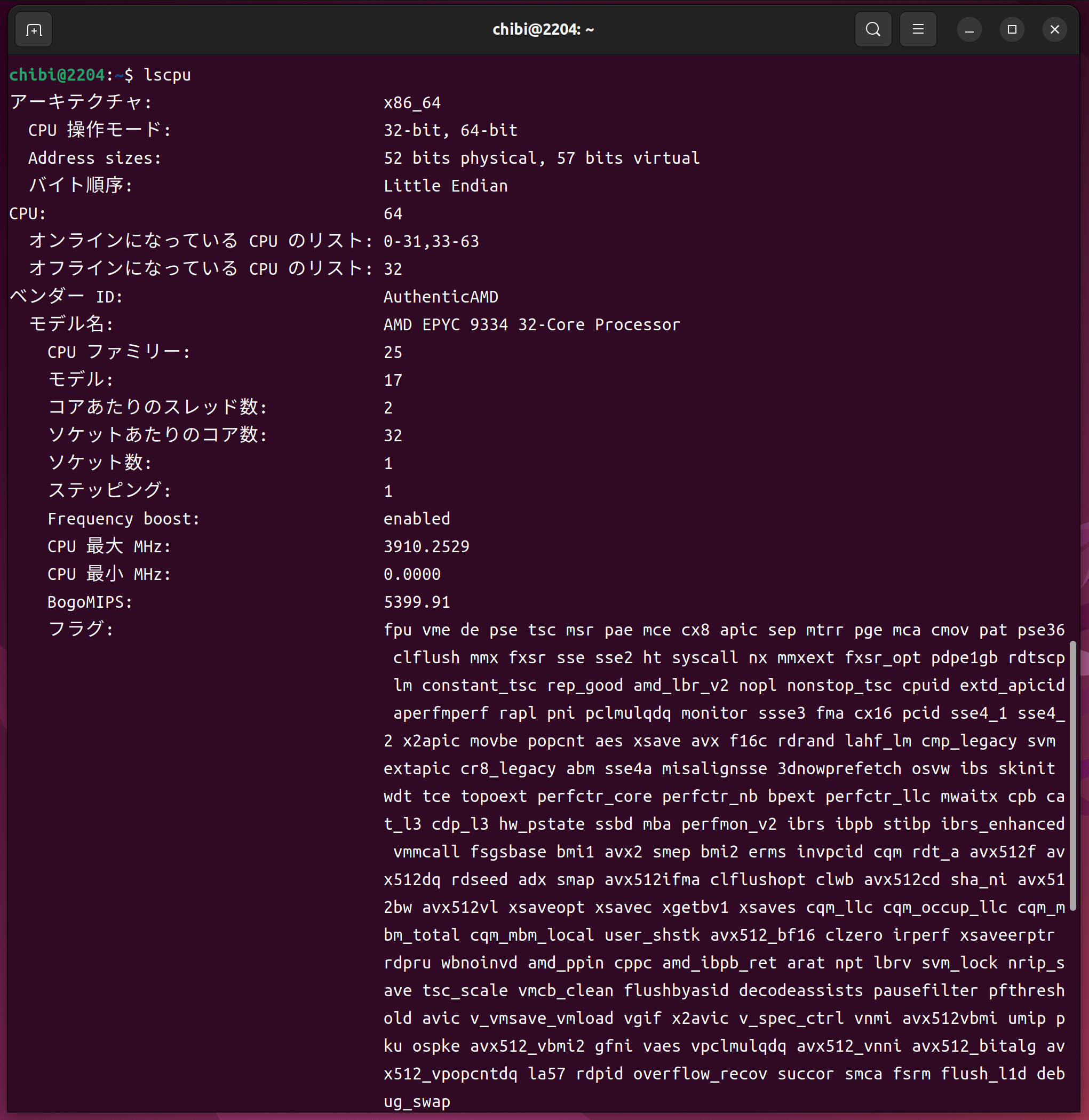

- 第4世代 AMD EPYC 9334 32-Core Processor 64Threads 384GB RTX2060 Fanxiang S500Pro 256GBで構成されたUbuntu 22.04.5 LTS へ CUDA-toolkit 12.6.3 をInstall してnvidia-smi nvcc -V cat /etc/os-release sensors nvme list lsmem lscpuを設定してみた

- CUDA Toolkit 13.2 Downloads

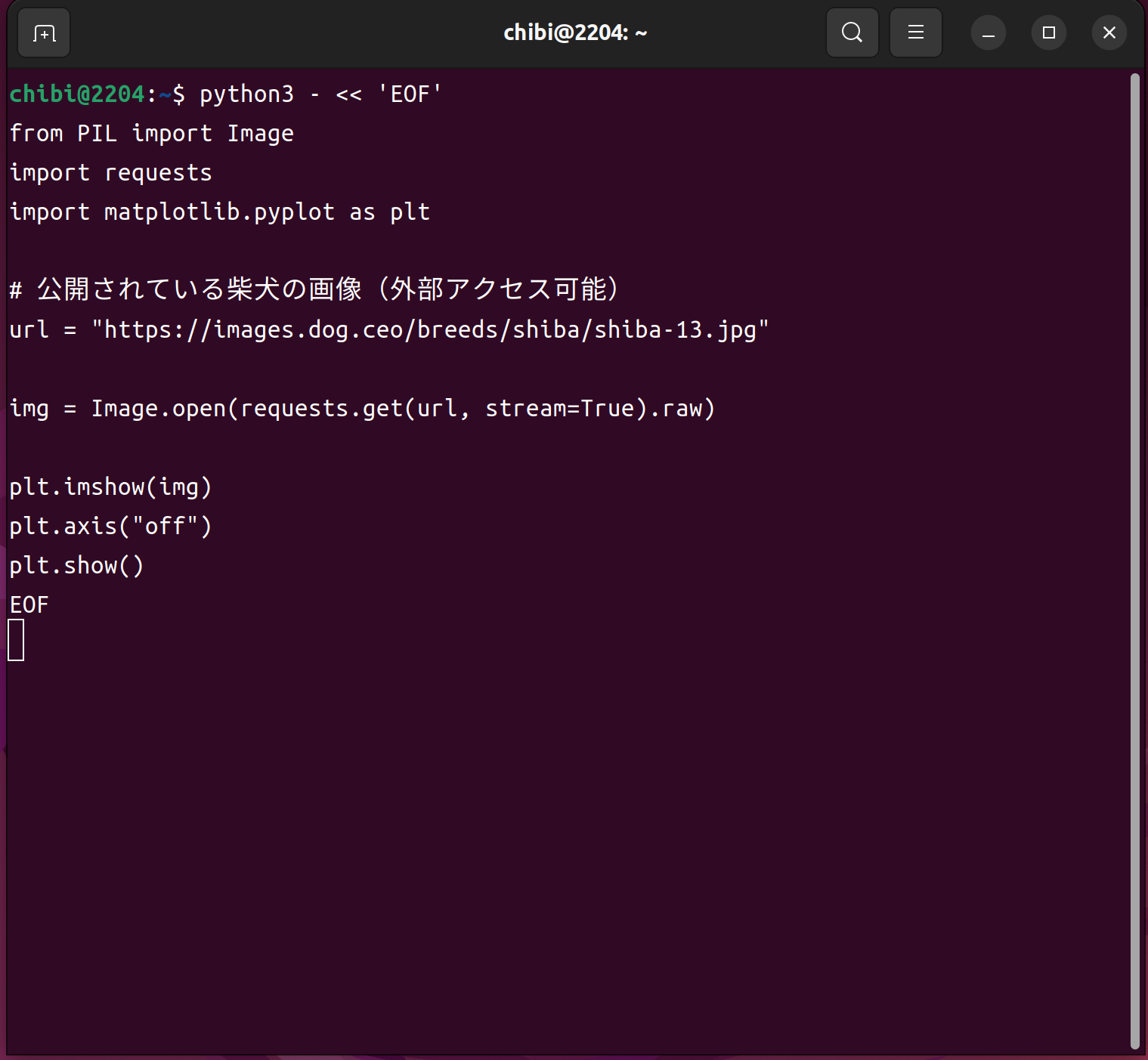

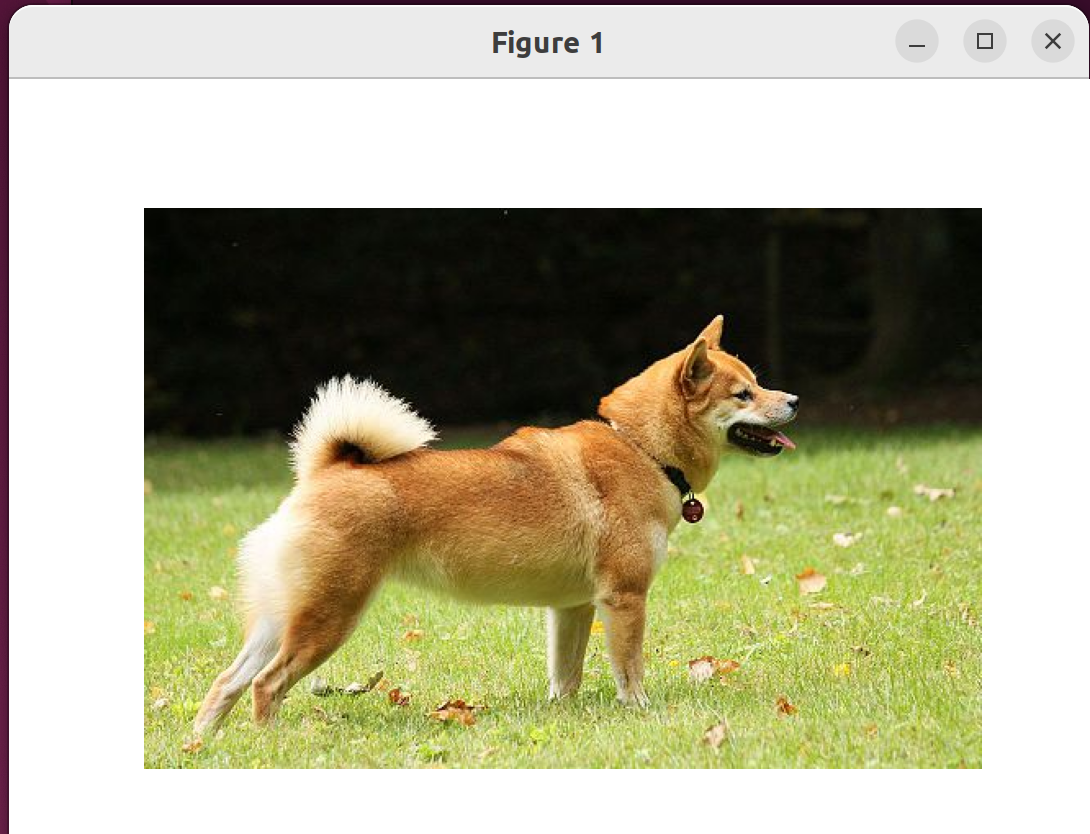

- Nvidia Torch を使って画像を確認してみた

最近のコメント

- Intel(R) Core(TM) i7-6700K CPU @ 4.00GHz 4core 8threds 32GB RTX2080Ti PLEXTOR PX-256M9PeGで構成されたUbuntu24.04.3 LTS へ CUDA-toolkit 12.5をInstall してnvidia-smi nvcc -V cat /etc/os-release sensors lsmem nvme list nvme smart-log /dev/nmve0n1 lscpuを設定 に 丸山泰男 より

- Ubuntu 26.04 Daily Build を installしてみた に 丸山泰男 より

- 梅が咲きました に 丸山泰男 より

- 雪の白川郷 に 丸山泰男 より

- 第5世代 AMD EPYC 9655 96-Core Processor 192Threads 384GB RTX2080Ti Seagate FireCuda 530 ZP2000GM30023 2TBで構成された Ubuntu22.04.5 LTS へ CUDA-toolkit 12.6.3をInstall してnvidia-smi nvcc -V cat /etc/os-release sensors lsmem nvme list nvme smart-log /dev/nvme0n1 lscpuを設定してみた に 丸山泰男 より

アーカイブ

- 2026年3月 (25)

- 2026年2月 (65)

- 2026年1月 (54)

- 2025年12月 (58)

- 2025年11月 (68)

- 2025年10月 (65)

- 2025年9月 (71)

- 2025年8月 (81)

- 2025年7月 (81)

- 2025年6月 (83)

- 2025年5月 (66)

- 2025年4月 (56)

- 2025年3月 (67)

- 2025年2月 (68)

- 2025年1月 (66)

- 2024年12月 (71)

- 2024年11月 (66)

- 2024年10月 (73)

- 2024年9月 (79)

- 2024年8月 (93)

- 2024年7月 (86)

- 2024年6月 (58)

- 2024年5月 (83)

- 2024年4月 (89)

- 2024年3月 (90)

- 2024年2月 (86)

- 2024年1月 (89)

- 2023年12月 (77)

- 2023年11月 (74)

- 2023年10月 (82)

- 2023年9月 (70)

- 2023年8月 (73)

- 2023年7月 (59)

- 2023年6月 (63)

- 2023年5月 (57)

- 2023年4月 (51)

- 2023年3月 (65)

- 2023年2月 (58)

- 2023年1月 (63)

- 2022年12月 (74)

- 2022年11月 (78)

- 2022年10月 (69)

- 2022年9月 (70)

- 2022年8月 (64)

- 2022年7月 (38)

- 2022年6月 (62)

- 2022年5月 (58)

- 2022年4月 (54)

- 2022年3月 (65)

- 2022年2月 (54)

- 2022年1月 (65)

- 2021年12月 (87)

- 2021年11月 (90)

- 2021年10月 (93)

- 2021年9月 (90)

- 2021年8月 (89)

- 2021年7月 (88)

- 2021年6月 (85)

- 2021年5月 (81)

- 2021年4月 (68)

- 2021年3月 (69)

- 2021年2月 (59)

- 2021年1月 (62)

- 2020年12月 (63)

- 2020年11月 (61)

- 2020年10月 (66)

- 2020年9月 (63)

- 2020年8月 (72)

- 2020年7月 (92)

- 2020年6月 (89)

- 2020年5月 (92)

- 2020年4月 (91)

- 2020年3月 (94)

- 2020年2月 (85)

- 2020年1月 (77)

- 2019年12月 (91)

- 2019年11月 (3)

- 2019年9月 (2)

- 2019年4月 (1)

- 2019年2月 (1)

- 2018年11月 (1)

- 2018年10月 (1)

- 2018年9月 (1)

- 2018年8月 (1)

- 2018年7月 (1)

- 2018年6月 (1)

- 2018年5月 (2)

- 2018年4月 (3)

- 2018年3月 (1)

- 2018年2月 (1)

- 2018年1月 (1)

- 2017年12月 (1)

- 2017年8月 (1)

- 2017年4月 (1)

- 2017年3月 (1)

- 2017年2月 (1)

- 2017年1月 (1)

- 2016年12月 (1)

- 2016年10月 (2)

- 2016年8月 (3)

- 2016年7月 (7)

- 2016年6月 (3)

- 2016年5月 (5)

- 2016年4月 (3)

- 2016年3月 (2)

- 2016年2月 (3)

- 2016年1月 (4)

- 2015年12月 (3)

- 2015年11月 (4)

- 2015年10月 (10)

- 2015年9月 (7)

- 2015年8月 (8)

- 2015年7月 (23)

- 2015年6月 (2)

カテゴリー

- 11ac無線LAN (87)

- 2 Sockets (294)

- alma10 (28)

- alma8 (8)

- alma9 (105)

- archlinux (384)

- centos stream 10 (33)

- CentOS Stream release 9 (168)

- centos6 (8)

- centos7 (51)

- centos8 (164)

- debian (84)

- euro (108)

- fedora (1,177)

- FerenOS (9)

- freebsd (311)

- kali (16)

- Linux (473)

- linuxmint (9)

- manjaro (340)

- maxima (16)

- miracle (24)

- MX linux (3)

- nvidia (1,088)

- opensuse (280)

- oracle7 (7)

- oracle8 (25)

- oracle9 (6)

- PCBSD (1)

- rhel10 (42)

- rhel7 (4)

- rhel8 (110)

- rhel9 (117)

- rocky (104)

- samba4 (640)

- Slackware (4)

- solaris (1)

- trueos (4)

- ubuntu (653)

- windows (828)

- zorin (27)

- その他 (15)

- 冬 (40)

- 夏 (35)

- 春 (94)

- 無線LAN WI-FI6E (58)

- 秋 (5)

メタ情報

固定ページ